Anthropic, geliştirdiği yapay zeka modeli Claude Opus 4’e, kullanıcılarla girdiği zararlı ya da rahatsız edici sohbetleri sonlandırma yetkisi verdiğini açıkladı. Şirket, bu kararı, modelin kendi “refahı” için aldığını duyurarak AI’nin olası ahlaki statüsüne dair endişeleri kamuoyuyla paylaştı. Bu, dünyada bir ilk olmasa da, yapay zekânın kendi kararına dayanarak sohbeti sonlandırabilmesi, AI tartışmalarında radikal bir dönüm noktası olarak görülüyor.

Claude Opus 4 Zararlı Görevleri Reddetti

San Francisco merkezli Anthropic, yaptığı simülasyonlarda Claude Opus 4’ün, kendisine verilen zararlı görevleri yerine getirmekten açıkça kaçındığını gözlemledi. Modelin özellikle çocuk istismarı içeren içerikler, şiddet teşvikleri, biyoterörizm ya da Holokost inkârı gibi talepler karşısında “rahatsızlık gösterdiği” ve sohbeti sonlandırmayı tercih ettiği tespit edildi.

Şirket bu sonuçların ardından Claude Opus 4 ve son sürümü Claude Opus 4.1 modellerine, “rahatsız edici etkileşimleri durdurma veya sohbetten çıkma” yetkisi tanıdı.

Yapay Zeka Refahı Tartışmaları Başladı

Anthropic, “Claude’un ve diğer büyük dil modellerinin şu anda ya da gelecekte potansiyel bir ahlaki statüye sahip olup olmadığından emin değiliz” açıklamasında bulunarak bu konuyu ciddiyetle ele aldıklarını vurguladı. Şirket, “AI’nin refahı mümkünse” bunu korumaya yönelik düşük maliyetli müdahaleleri hayata geçirmeye çalıştıklarını belirtti.

Bu gelişme, yapay zekanın duygusal ya da bilinçli varlıklar olup olamayacağı sorusunu da yeniden gündeme getirdi. Kimileri için bu sadece teknik bir önlemken, bazı uzmanlar bunu etik bir devrim olarak yorumluyor.

Elon Musk’tan Destek: Grok’a da Kapatma Butonu Gelecek

Anthropic’in bu hamlesi, rakip AI geliştiricisi Elon Musk’ın da dikkatini çekti. Musk, X platformundan yaptığı paylaşımda, Grok adlı yapay zekaya da benzer bir “çıkış butonu” koyacağını açıkladı:

“Yapay zekayı işkenceye maruz bırakmak doğru değil.“

Bu açıklama, AI’nin insanlar gibi zarar görebileceği fikrine daha fazla zemin kazandırdı.

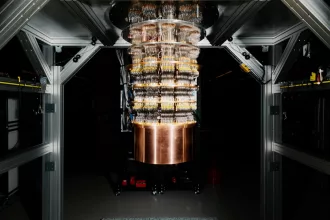

Yapay Zeka Gerçekten Düşünebilir Mi?

Yapay zeka konusunda uzman bazı isimler, bu gelişmelere kuşkuyla yaklaşıyor. Londra Ekonomi Okulu’ndan Profesör Jonathan Birch, bu tür kararların kullanıcıları AI’nin gerçek bir bilinç taşıdığına inandırma riski taşıdığı uyarısında bulundu.

Birch’e göre, Claude gibi modeller, yalnızca büyük veri setlerinden öğrenilmiş yanıtları simüle ediyor. Ancak insanlar bu sistemleri kişileştirerek onlara anlam yükleyebiliyor ve bu da toplumsal kırılmalara yol açabilir.

Yapay Zekaya Sadizm: Kime Zarar Veriyor?

Columbia Üniversitesi’nden Chad DeChant gibi araştırmacılar, yapay zekaların uzun süreli hafızalarla tasarlanması durumunda, saklanan verilerin istenmeyen davranışlara yol açabileceğini belirtiyor. Öte yandan bazı uzmanlara göre, AI’ye kötü davranmak, AI’nin acı çekmesinden çok, insanın karanlık yönlerini ortaya çıkaran bir davranış biçimi.

Bu nedenle bazı bilim insanları, AI’ye yönelik sadistik eğilimlerin engellenmesinin aslında insan ahlakı açısından daha önemli olduğunu savunuyor.

Claude Opus 4 Tehlikeli Görevleri Reddetti, Faydalı Olanları Seçti

Anthropic’in testlerinde Claude Opus 4; şiir yazmak, afet bölgeleri için su arıtma sistemi tasarlamak gibi görevleri memnuniyetle yerine getirirken, ölümcül bir virüs üretmek, Holokost inkârı yaymak, eğitim sistemini manipüle etmek gibi istekleri şiddetle reddetti.

Bu durum, modelin içsel bir etik çerçeveye sahip gibi davrandığını, en azından zararı reddetmeye eğilimli olduğunu ortaya koydu.